4609

4609

Что такое RTDF (и как с ним бороться)

Данная статья является кратким авторизованным обзором материала, опубликованным тремя исследователями – Govind Mittal, Chinmay Hegde и Nasir Memon из Департамента компьютерных наук университета Нью-Йорка (Dept. of Computer Science and Engineering, New York University)

Используемые аббревиатуры

DFL – DeepFaceLab: Integrated, flexible and extensible face-swapping framework

LIA – Latent image animator: Learning to animate images via latent space navigation

FSGAN – Fsganv2: Improved subject agnostic face swapping and reenactment generative adversarial network

В современном мире роль онлайн-взаимодействия постоянно растет. Проведенные в 2023 году опросы свидетельствуют о том, что 86% компаний проводят собеседования на предмет трудоустройства в онлайн-режиме, а 83% работников проводят до трети рабочего времени на виртуальных встречах.

Данное обстоятельство создает плодотворную почву для новых атак с использованием социальной инженерии. Появление в открытом доступе инструментов, позволяющих убедительно представлять внешность выбранной жертвы, дает возможность обманывать системы биометрической аутентификации и системы обнаружения атак на биометрическое предъявление. Если раньше в качестве жертв выбирались публичные фигуры, то в настоящее время технологии позволяют создавать такие видео даже для рядовых пользователей и при весьма небольшом количестве изображений для тренировки нейронной сети, создающей Deep Fake в режиме реального времени.

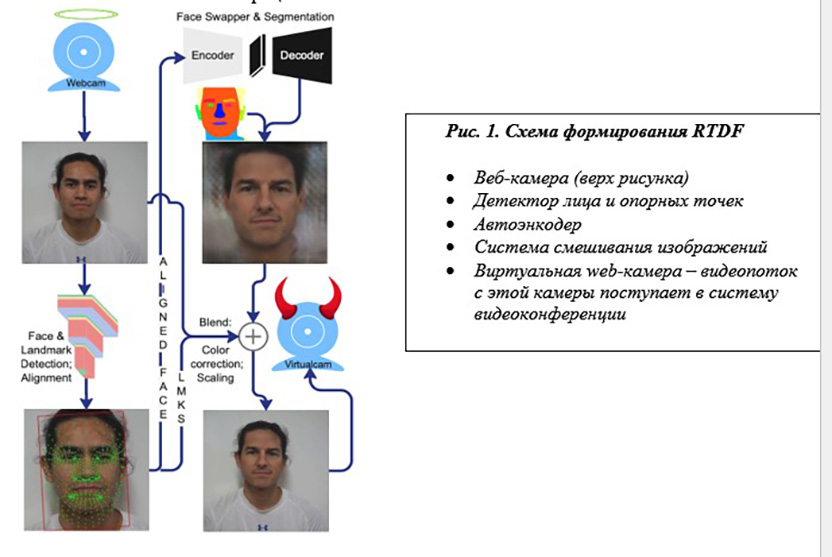

Такие системы, получившие название Real Time Deep Fake (RTDF), являются усложненным вариантом создания Deep Fake и позволяют вести интерактивное взаимодействие от лица намеченной жертвы в процессе онлайн-видеосвязи. Уже имеется достаточное количество примеров, когда использование технологии RTDF позволило ввести в заблуждение сотрудников, что приводило к весьма существенным финансовым потерям.

Авторы настоящей статьи исходили из модели угроз, в которой имеются всего три субъекта: злоумышленник (атакующий), жертва и защищающаяся сторона. Защищающаяся сторона намерена провести сеанс видеосвязи с жертвой, а злоумышленник выдает себя за жертву, используя лицевую биометрию жертвы. Такая модель характерна для процедур KYC (Know Your Customer), проводимых в онлайн-режиме. Обычно при таких процедурах просят предъявить документ, удостоверяющий личность, для сравнения с предъявляющим его субъектом.

Заметим, что технологии DeepFake имеют возможность изменить и фотографию на документе. Такие технологии KYC применяют необанки для открытия счета. Аналогичный подход к предоставлению услуг используют такие компании, как Uber, Airbnb и агентства США, использующие технологию US ID.me. Аналогичная технология используется и российскими микрофинансовыми организациями в процессе выдачи кредитов и каршеринговыми компаниями при первичной регистрации пользователя сервиса. Проведение онлайн-экзаменов также основано на таком подходе, и успешный прием на удаленную работу в крупные западные компании северокорейских хакеров тоже имел в основе аналогичный процесс.

На пути создания убедительного RTDF существует достаточно большое количество препятствий, перечисленных ниже:

-

Необходимость большого набора данных для генерации качественного видеопотока. Так, использование для генерации нейросети DeepFaceLab требует наличия около 4 тысяч изображений жертвы в разных ракурсах и условиях освещения с высоким разрешением. В то же время имеются и более поздние технологии, которые могут оживить единственную фотографию и заставить ее разговаривать и воспроизводить мимику, но они гораздо более чувствительны к изменению условий при выполнении поставленных защищаемым задач.

-

Желательность сходства формы лица атакующего злоумышленника и жертвы.

-

Цвет кожи тоже должен совпадать, но это можно компенсировать использованием технологии переноса цвета.

-

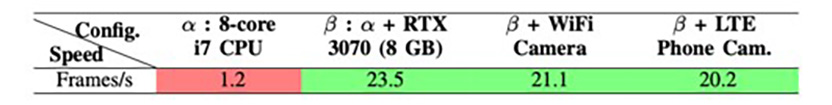

Вычислительные мощности для создания RTDF, в противном случае не удастся получить приемлемое качество и нужную частоту кадров в видеопотоке (не менее 15 кадров/сек.). В таблице 1 приведены необходимые требования к оборудованию для использования в рамках решения DeepFaceLab.

Таб. 1. Зависимость производительности системы генерации RTDF от оборудования (красным цветом отмечена недостаточная производительность – менее 15 кадров/сек.)

Заметим, что любые действия на стороне атакующего создают дополнительную нагрузку на оборудование, что может вызывать визуально заметные артефакты – потеря кадров, размытие движущихся предметов, пропадание изображения лица или его видимые искажения.

Облачные провайдеры (например, Google CoLab) ввели ограничения на тренировку моделей на своей платформе, что становится дополнительным ограничением для атакующего.

Необходимый уровень знаний и повторное обучение генератора – каждая новая жертва требует переобучения генератора, что невозможно без нужного уровня технических компетенций и временных затрат.

Таким образом, атакующая сторона должна будет обойти перечисленные выше и, возможно, другие попутные препятствия для создания убедительного видеопотока.

Существующие механизмы обнаружения Deep Fake не могут быть использованы для борьбы с RTDF в силу того обстоятельства, что они не предполагают использования в онлайн-режиме и интерактивного взаимодействия. Несмотря на существенный прогресс в области обнаружения видеоподделок, алгоритм их работы не использует никакого взаимодействия между атакующим и защищающимся, что дает преимущество атакующему.

Авторы приведенной работы решили подойти к решению проблемы с другой стороны – защищающийся может попросить противоположную сторону (атакующего) о проведении действий (поворот головы, включение освещения и др.), которые могут вызвать проблемы в процессе генерации видеоизображения, что создает видимые для защищающегося артефакты. По аналогии с широко известным механизмом CAPTCHA авторы нового подхода предложили назвать его GOTCHA. Основной проблемой концепции является выбор таких задач для атакующего, которые, с одной стороны, не выходят за рамки поведения, а с другой – создают проблемы для системы генерации Deep Fake, вызывая такие артефакты в видеопотоке, которые легко замечает защищающийся.

Авторы сформулировали, какими должны быть задачи, поставленные перед атакующим:

-

Должны вызывать артефакты, которые могут быть обнаружены как визуально, так и с помощью автоматизированных решений.

-

Могут быть легко реализованы на стороне атакующего.

-

Задача должна иметь параметры, которые могут быть заданы в произвольном порядке.

-

Для обнаружения факта атаки защищающая сторона выбирает случайным образом действие, которое должен выполнить атакующий, – например, атакующий должен повернуть голову на 45 градусов и затем посмотреть вниз за определенное время, создавая каждый раз задачу с отличающимся действием. Для удобства защищающийся может либо сам продемонстрировать нужное действие, либо использовать анимированный аватар на экране в процессе видеоконференции.

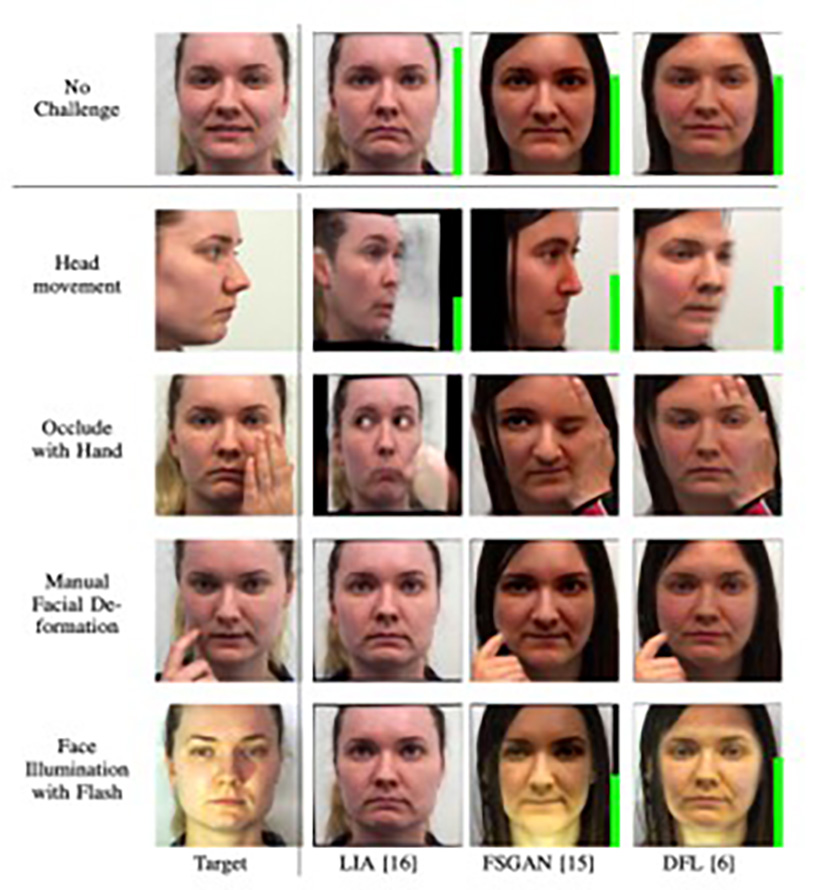

Движение головы – атакующего просят произвести движение головы – поворот, наклон, покачивание головой. Такие движения создают проблемы при генерации видеопотока с помощью RTDF.

Закрытие части лица – атакующего просят закрыть часть лица. Для этого могут быть использованы:

-

Рука;

-

Имеющийся у атакующего предмет – очки, авторучка.

Деформация лица – задача, призванная вызвать изменение лица, например:

-

атакующего просят прижать палец к щеке или подбородку;

-

изменение выражения лица – широкая улыбка, приподнятые брови, сморщенное лицо и т. д.

Освещение лица – задача, которая состоит в изменении освещения лица атакующего. Данная задача может быть выполнена:

-

атакующим по просьбе защищающегося включением дополнительного источника света или изменением местоположения источника света;

-

за счет подсветки экраном на стороне атакующего – например, изменение свечения экрана у защищающегося должно вызывать изменения и на стороне атакующего.

На рис. 2 приведены примеры артефактов, созданных с помощью различных нейросетей и возникающих при выполнении действий, которые просит выполнить защищающаяся сторона. Зеленые столбцы в правой части изображений характеризуют степень соответствия видеоизображения реальному.

Рис. 2. Примеры возникающих артефактов для различных нейросетей, создающих RTDF (в левой колонке – реальное видеоизображение)

Проведенные авторами исследования, по их собственному мнению, позволяют сделать следующие выводы:

-

Использование предлагаемой технологии позволяет создавать артефакты, которые могут быть достаточно легко замечены защищающейся стороной.

-

Вызываемые артефакты могут легко обнаруживаться нейронными сетями, которые предварительно должны быть обучены на их фиксацию.

-

Совместное применение автоматических решений и операторов позволяет повысить уровень обнаружения артефактов.

-

Использование собственного датасета RTDF в процессе исследований не позволяет сделать оценки возможного влияния демографии.

-

В качестве мер противодействия предлагаемой технологии на стороне атакующих можно предвидеть дообучение нейросетей для создания RTDF.