2311

2311

Защищаемся от состязательных атак

Системы лицевой биометрии, в настоящее время в большинстве своем основанные на нейронных сетях, уязвимы для атак на биометрическое предъявление, и одной из разновидностей таких атак являются состязательные атаки (adversarial). В чем особенности данных атак? Эти атаки направлены на искажения работы классификаторов, лежащих в основе систем распознавания. Данные атаки в чем-то сродни оптическим иллюзиям, которые возникают при определенных условиях у людей.

Принято разделять такие атаки на два типа по поставленной задаче:

- Атаки уклонения (dodging attacks) — атакующий ставит задачу неправильной классификации объекта, при этом неважно, как будет классифицирован объект и к какому классу он будет отнесен. Такой подход интересен злоумышленнику, который опасается, что будет опознан биометрической системой, и желает, чтобы идентификация не смогла надежно установить его личность.

- Таргетированные атаки (targeted attacks) — атакующий хочет выдать один объект (или субъект) за другой — например, получить доступ к финансовым инструментам, которые используют биометрическую верификацию для процесса аутентификации/идентификации клиента. Очевидно, что второй тип атак более сложен, но и более перспективен с точки зрения атакующих. Иногда эти атаки называют имперсонификацией.

Об актуальности данной тематики можно судить по следующему факту — в 2014 году публикации о теоретических исследованиях и практических экспериментах в данной области отсутствовали, а в 2022 году таких публикаций было несколько десятков.

Классификация сценариев атак может быть основана на том, когда происходит манипуляция с работой классификаторов. Принято выделять три возможных варианта:

- «Отравление данных (Data poisoning)» — в процессе обучения нейронной сети в набор данных, используемых для тренировки модели, случайно или намеренно попадают данные, провоцирующие неустойчивую работу классификаторов, что может привести к ошибкам в процессе эксплуатации обученной на «отравленном» датасете модели.

- «Предъявление состязательного примера (Evasive attack)» — обученной системе предъявляется артефакт или субъект, который нарушает работу классификаторов и позволяет либо провести уклонение от опознания, либо (в случае таргетированной атаки) выдать один артефакт (или субъект) за другой. Такие атаки можно дополнительно разделить на две группы:

- Whitebox — у атакующего есть полная информация об архитектуре и параметрах нейронной сети, используемой в системе распознавания, и имеется доступ к системе принятия решений модели;

- Blackbox — у атакующего отсутствует информация об архитектуре и настройках модели, но имеется возможность получения отклика модели в режиме «да-нет».

- «Извлечение модели (model extraction)» — использование состязательного примера для получения либо набора данных, использованных для обучения модели, либо самой модели для последующего неправомерного использования. Извлеченные данные могут быть конфиденциальными, а похищенная модель может быть использована в целях получения финансовой или иной выгоды.

- могут быть реализованы в виде, который не вызывает подозрений у возможных посторонних наблюдателей;

- стоимость изготовления состязательного примера ниже выгоды, получаемой в результате реализации атаки.

Надо отдавать себе отчет, что далеко не все известные состязательные примеры (а их действительно много) могут быть реализованы на практике. Так, например, широко известный пример «панда — гиббон (рис. 1)», использующий добавление определенного вида шумов в изображение, не может быть реализован без доступа к подаваемому на вход модели видеосигналу, что в большинстве случаев биометрических систем исключается по соображениям безопасности. То есть далеко не все возможные в цифровом мире манипуляции можно перенести в реальный физический мир.

Рис. 1. Известный пример «панда — гиббон»

Для практических целей наиболее интересными являются состязательные примеры, отличающиеся следующим:

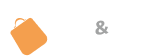

Примером состязательной атаки в «физическом» мире можно считать специально разработанные очки (рис. 2), которые позволяют осуществлять таргетированную атаку. Представленные в верхнем ряду фотографии — это атакующие в очках, в нижнем ряду — результат идентификации субъекта в очках. Разработчики утверждают, что стоимость изготовления таких очков составляет около 22 долларов США, правда, не приводят данных, сколько машинного времени потребовалось для разработки таких очков.

Рис. 2. Таргетированная атака с помощью очков

В настоящее время нет сообщений об использовании состязательных атак злоумышленниками в финансовой сфере, вся информация в основном публикуется разработчиками нейронных сетей. В распоряжении исследователей имеется целый ряд технологий для создания состязательных примеров как для whitebox, так и для blackbox вариантов, и основное внимание специалистов-разработчиков направлено на сокращение затрат при генерации состязательных примеров. Поскольку прогресс в области создания инструментов для состязательных атак налицо, то имеется целый ряд исследований, направленных на защиту нейронных сетей от таких атак, и можно утверждать, что имеется некое динамическое равновесие между средствами нападения и защиты.

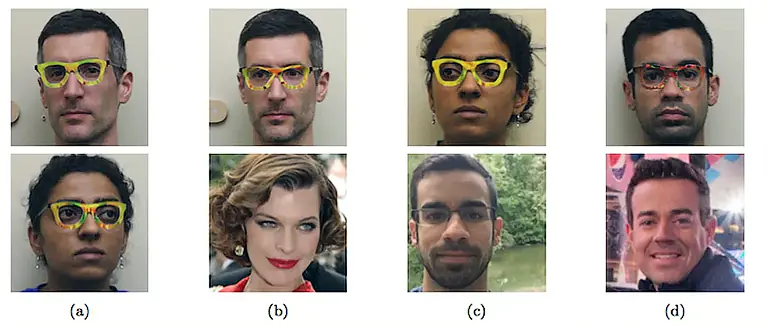

Интересным примером состязательных атак является их применение для целей обеспечения приватности, защищая от опознания системами видеонаблюдения людей, размещающих свои биометрические данные в социальных сетях и на просторах интернета. Так, группа исследователей из университета штата Мэриленд разработала программу, которая вносит элементы состязательных примеров в фотографию. Фотография после обработки легко распознается человеком, но использование обработанной фотографии в системах идентификации практически невозможно (рис. 3).

Рис. 3. Верхний ряд — исходное фото, нижний — обработанное изображение

Разработчики проверили результаты работы программы на коммерчески используемых продуктах: Amazon Rekognition и Microsoft Azure Face Recognition. Вероятность распознавания составила 0,6% для первого и 0,1% для второго решения. Заметим, что алгоритмы данных продуктов недоступны, и фактически имеет место атака на нейронную сеть в режиме blackbox.

И еще одна не слишком известная особенность нейронных сетей — они могут быть весьма эффективны в качестве средства скрытной доставки зловредных приложений. Параметры нейронной сети зашифрованы, и стандартные средства антивирусной защиты не могут обнаружить зловредное ПО, размещенное в этих файлах. Более того, имеется возможность активации такого ПО в заданный момент, по предъявлению какого-либо сигнала, распознаваемого нейронной сетью, а до этого момента активность отсутствует.

Для обученной нейронной сети AlexNet (размер приложения 178 MB) объем зловредной нагрузки может составлять 39 MB при незначительном ухудшении качества. Такая атака может быть реализована как вариант атаки Supply Chain, которая продемонстрировала свою эффективность в предыдущие годы. Предлагаемый вариант защиты — переобучение сети на собственных обученных нейронных сетях — зачастую используется как компонент собственного решения.